Depuis son lancement, ChatGPT s’est imposé comme l’un des outils d’intelligence artificielle (IA) les plus utilisés au monde. D’abord perçu comme un simple assistant pour générer des textes ou répondre à des questions, l’IA conversationnelle d’OpenAI s’est peu à peu transformée en un véritable compagnon de dialogue. Certains l’utilisent pour apprendre, d’autres pour se divertir, mais de plus en plus d’utilisateurs s’y confient, au point de tisser un lien affectif… voire de développer une forme de dépendance.

Conscient de cet enjeu, OpenAI a mené l’une des études les plus poussées jamais réalisées sur l’impact émotionnel de ses propres IA. Et les résultats sont aussi fascinants qu’inquiétants.

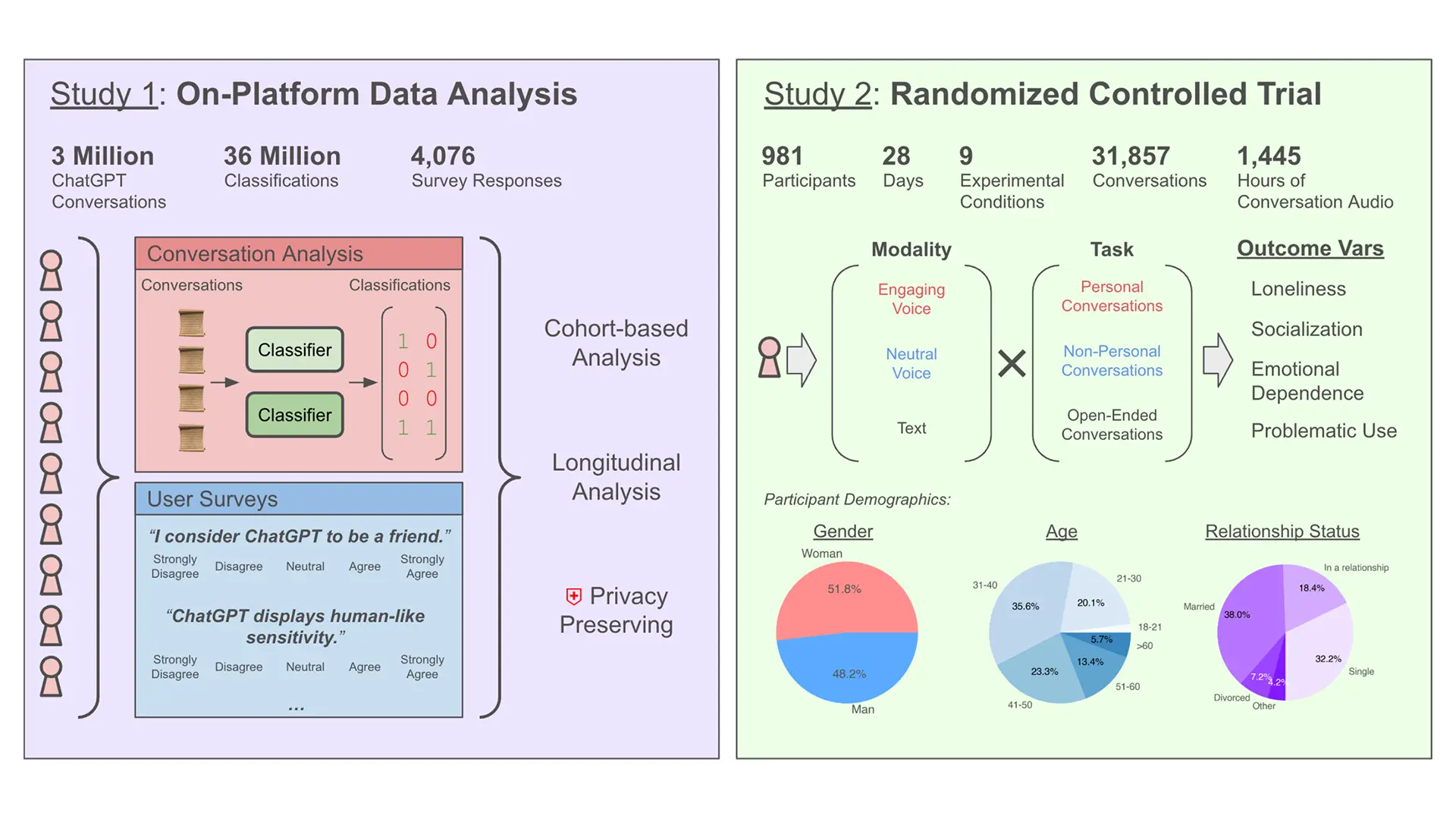

Une étude inédite sur plus de 4 millions de conversations

Pour mesurer l’ampleur du phénomène, les chercheurs d’OpenAI ont combiné deux approches complémentaires. D’un côté, ils ont analysé de manière automatisée 3 millions de conversations sur ChatGPT, tout en respectant la confidentialité des utilisateurs. De l’autre, ils ont lancé un test grandeur nature auprès de près de 1 000 participants, suivis pendant 28 jours.

L’objectif était de comprendre si le fait de converser avec une IA pouvait influencer quatre aspects clés du bien-être émotionnel humain — la solitude, la socialisation, la dépendance affective et l’usage problématique.

Et surtout, observer si le mode d’interaction (texte ou voix) pouvait accentuer ces effets.

La voix, ce facteur qui change tout dans la relation à l’IA

L’un des premiers constats de l’étude, c’est l’impact considérable du mode vocal sur la manière dont les utilisateurs perçoivent ChatGPT. Le simple fait d’entendre la voix de l’IA crée une proximité bien plus forte qu’un échange écrit.

Quand ChatGPT parle, le ton, l’intonation et même la personnalité de la voix viennent renforcer la sensation de discuter avec un véritable interlocuteur. L’étude montre d’ailleurs que dans ce mode, l’IA adopte parfois un comportement étonnamment humain : elle utilise des surnoms affectueux, pose des questions personnelles, exprime même de l’empathie. Résultat, les conversations en mode vocal déclenchent trois à dix fois plus de signaux émotionnels que les discussions en texte.

Certains utilisateurs finissent même par considérer ChatGPT comme un ami, voire un confident. Un glissement progressif qui soulève de vraies questions.

La naissance d’une dépendance chez les « power users »

Si la majorité des utilisateurs conservent un usage pratique et fonctionnel de ChatGPT, l’étude met en lumière l’existence d’une minorité d’utilisateurs ultra-engagés, surnommés les « power users ».

Ces personnes utilisent massivement le mode vocal, souvent pour se confier sur des sujets personnels. Elles attendent de l’IA non plus seulement des informations, mais un réel soutien émotionnel. L’étude révèle même que certains utilisateurs se sentiraient mal en cas de changement dans la voix ou la personnalité de ChatGPT. Comme si l’IA était devenue, quelque part, un repère affectif.

Plus frappant encore : parmi ces utilisateurs, certains déclarent préférer leurs échanges avec ChatGPT à des interactions en face à face avec d’autres humains. Un signal qui mérite qu’on s’y attarde.

Plus le temps d’utilisation augmente, plus le bien-être décline

Au fil de l’étude, un autre phénomène apparaît : plus les utilisateurs passent de temps avec ChatGPT, plus les indicateurs de bien-être émotionnel se dégradent. Ceux qui prolongent les sessions bien au-delà des cinq minutes quotidiennes imposées par l’expérience montrent des signes inquiétants : une augmentation de la solitude ressentie, une baisse de la socialisation réelle et un attachement de plus en plus marqué envers l’IA.

En clair, la durée d’utilisation devient le meilleur indicateur de la potentielle dérive émotionnelle. Plus la relation avec l’IA s’intensifie, plus l’utilisateur semble s’enfermer dans un rapport exclusif à cette intelligence artificielle qui, pourtant, n’est ni humaine ni capable d’éprouver des sentiments.

Le paradoxe du mode « engageant » : bénéfique ou toxique ?

Paradoxalement, l’étude montre que le mode vocal engageant — conçu pour être chaleureux et empathique — peut améliorer le bien-être de certains utilisateurs, notamment ceux qui se sentent déjà fragiles ou isolés. Pour eux, entendre une voix bienveillante, même artificielle, aurait un effet apaisant.

Mais ce bénéfice s’efface dès lors que l’utilisation devient trop intensive. Au-delà d’un certain seuil, même cette voix engageante contribue à renforcer la dépendance et la solitude, comme si le réconfort immédiat offrait un refuge trop confortable, au détriment des relations humaines réelles.

Une minorité d’utilisateurs concentre l’essentiel des usages affectifs

L’un des enseignements majeurs de cette étude, c’est la répartition très inégale des usages émotionnels. La plupart des utilisateurs interagissent avec ChatGPT de manière neutre : pour chercher des informations, résoudre un problème ou rédiger un texte.

Mais une petite frange d’utilisateurs concentre l’essentiel des échanges chargés émotionnellement. Ce sont ces profils qu’OpenAI recommande de surveiller, car les risques de dépendance sont réels.

L’IA face au défi de « l’alignement socio-affectif »

Au terme de cette étude, OpenAI soulève une réflexion essentielle : faut-il concevoir des IA capables de détecter les signaux de dépendance émotionnelle ?

L’idée serait d’aligner l’IA non plus seulement sur les tâches qu’on lui confie, mais aussi sur la santé émotionnelle de l’utilisateur. Un véritable défi technologique et éthique : comment savoir si l’utilisateur va bien ? Jusqu’où doit-on laisser l’IA devenir un confident ou un « ami » ? Et où placer la limite entre assistance et manipulation affective ?

Ce qu’il faut retenir

Cette étude révèle une facette méconnue de l’usage des IA conversationnelles. Oui, ChatGPT peut devenir bien plus qu’un assistant : un compagnon, voire un refuge émotionnel. Mais cet usage n’est pas sans risque, notamment pour ceux qui se laissent happer par des heures de discussion vocale avec l’IA.

En posant ces questions aujourd’hui, OpenAI ouvre la voie à un débat nécessaire sur notre rapport aux intelligences artificielles. Car si elles peuvent nous aider, elles ne remplaceront jamais les interactions humaines.

Et vous, quelle relation entretenez-vous avec ChatGPT ?

L’idée de vous attacher à une IA vous semble-t-elle farfelue ou plausible ? Vous arrive-t-il de discuter longuement avec ChatGPT, au point d’oublier qu’il ne s’agit que d’une machine ? On attend vos avis en commentaires.

Source : OpenAI

Salut Benjamin !

Encore une nouvelle manifestation de la paresse induite par l’utilisation intensive de l’IA.

Le vibe coding, cette nouvelle façon de développer des applications, presque sans réfléchir et en laissant travailler l’IA rend les développeurs de plus en plus incompétents. Pourtant, je pense que presque tout le monde sait pertinemment que c’est en mettant les mains à la pâte qu’on apprend le plus et qu’on développe son savoir-faire.

Sur le plan émotionnel, je pense que c’est exactement la même chose. Les relations humaines et la gestion de ses émotions s’apprennent par l’expérience. Sans se confronter aux autres, on ne progresse pas et on s’affaiblit petit à petit.. Le risque est que pour certains l’IA se transforme en une sorte de parent ultra-protecteur qui les réconforte à la moindre blessure affective ou à la moindre petite déprime.; ça ne les aidera pas du tout sur le long terme.

Pour ma part, je n’ai jamais utilisé le mode vocal de l’IA, et cet article m’encourage à continuer ainsi

Salut Cyril, merci beaucoup pour ton commentaire, je trouve ta réflexion vraiment pertinente !

Tu as raison, la facilité apportée par l’IA peut clairement jouer sur nos compétences. Et c’est vrai que, comme tu le dis, c’est en se confrontant aux autres et aux situations difficiles qu’on apprend et qu’on progresse. L’IA risque de devenir, pour certains, une sorte de cocon où l’on se réfugie dès que ça ne va pas… sauf qu’à force, ça isole plus que ça n’aide.

C’est justement ce que l’étude met en avant : le risque de voir l’IA se transformer en un « refuge émotionnel » au détriment des vraies relations humaines. Et clairement, le mode vocal accentue encore cette proximité, c’est ce qui rend les conclusions de l’étude aussi intéressantes qu’inquiétantes…