Ce n’est plus un secret pour les webmasters : afin d’alimenter et d’entraîner les IA génératives telles que ChatGPT, Gemini ou encore Claude, ces dernières n’hésitent pas à déployer des armées de robots qui scannent le Web en quête d’un maximum d’informations. Ces robots, aussi appelés « crawlers » ou « spiders », parcourent inlassablement les sites web, indexant chaque page, chaque image, chaque vidéo rencontrée.

Si cette collecte de données à grande échelle permet certes aux intelligences artificielles de s’améliorer et de proposer des réponses toujours plus pertinentes, elle soulève néanmoins de nombreuses questions, notamment en termes de respect de la propriété intellectuelle et de protection des données. En effet, les contenus ainsi aspirés par les robots se retrouvent intégrés dans les modèles de langage, sans que les créateurs de ces contenus n’aient donné leur accord ni ne soient rémunérés.

Face à cette situation, de plus en plus de propriétaires de sites internet cherchent des solutions pour empêcher ces robots indélicats de piller leurs précieuses ressources. Heureusement, il existe plusieurs méthodes pour bloquer l’accès de votre site aux robots d’IA les plus gourmands. Nous allons vous présenter ici les deux principales : la modification du fichier robots.txt et l’utilisation des outils de Cloudflare.

Méthode n°1 : Bloquer manuellement les robots IA dans le fichier robots.txt

La première solution consiste à mettre à jour manuellement le fichier robots.txt de votre site web. Ce fichier texte spécial, situé à la racine de votre site, permet de donner des instructions aux robots sur les pages qu’ils peuvent ou ne peuvent pas explorer. Pour bloquer spécifiquement les robots IA, vous devrez ajouter les directives suivantes à votre fichier robots.txt :

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: Google-Extended

Disallow: /

User-agent: PerplexityBot

Disallow: /

User-agent: Amazonbot

Disallow: /

User-agent: ClaudeBot

Disallow: /

User-agent: Omgilibot

Disallow: /

User-agent: FacebookBot

Disallow: /

User-agent: Applebot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Bytespider

Disallow: /

User-agent: Claude-Web

Disallow: /

User-agent: Diffbot

Disallow: /

User-agent: ImagesiftBot

Disallow: /

User-agent: Omgili

Disallow: /

User-agent: YouBot

Disallow: /

Chaque directive « User-agent » correspond à un robot IA spécifique, tandis que la directive « Disallow: / » qui suit indique au robot qu’il n’a pas le droit d’explorer l’ensemble des pages de votre site. N’hésitez pas à compléter cette liste avec d’autres robots IA que vous souhaiteriez bloquer.

Si vous n’êtes pas à l’aise avec l’édition manuelle du fichier robots.txt, vous pouvez utiliser un générateur en ligne comme https://www.generaterobotstxt.com/. Ce site propose une interface conviviale pour créer votre fichier robots.txt sur mesure, avec une option dédiée au blocage des robots IA. Il ne vous restera plus qu’à l’importer à la racine du serveur de votre site web.

Méthode n°2 : Activer le blocage des robots IA sur Cloudflare

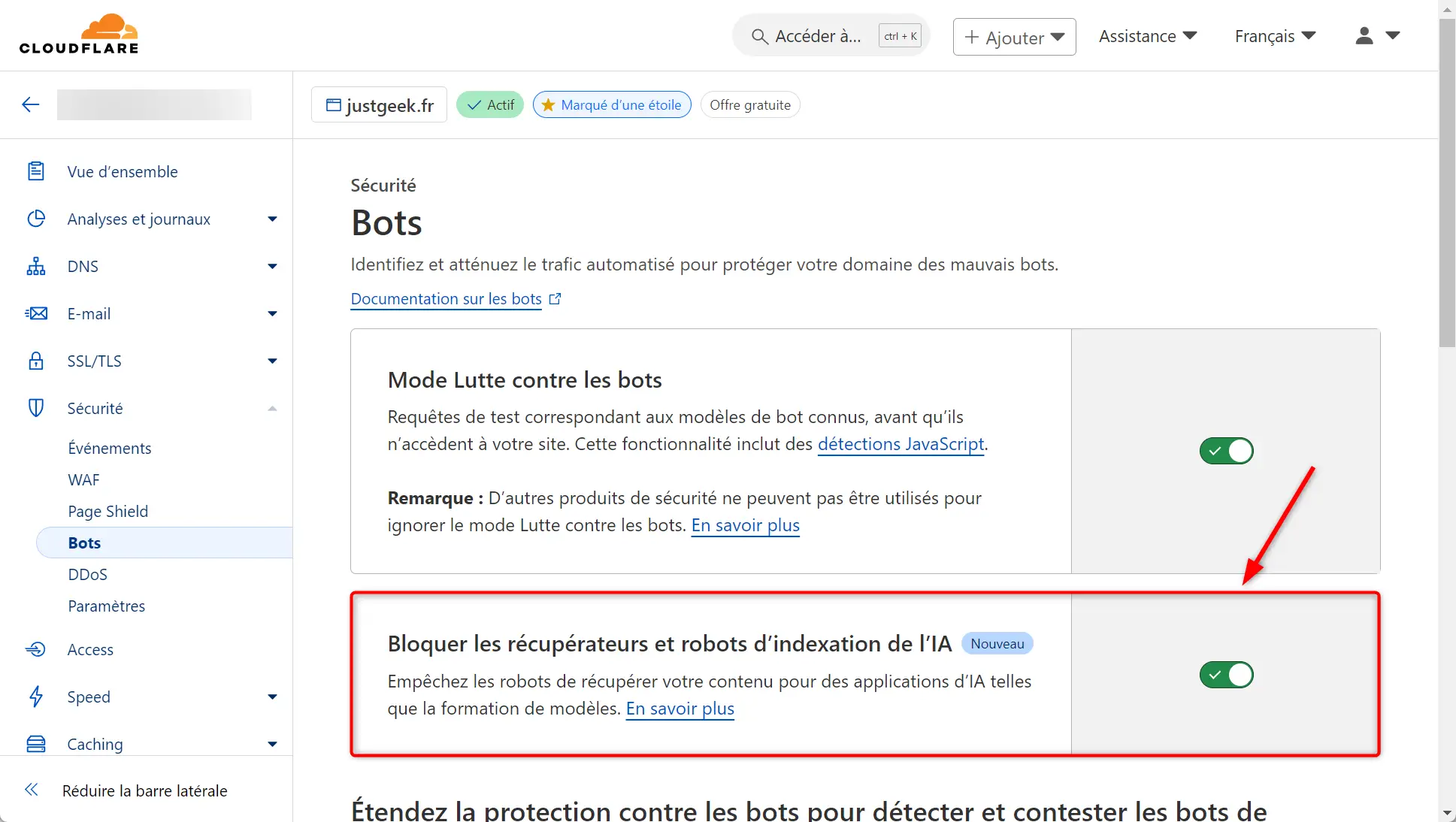

Si vous utilisez Cloudflare comme CDN (Content Delivery Network) pour votre site web, vous avez la chance de pouvoir profiter d’une fonctionnalité native pour bloquer les bots IA en un clic. Voici comment procéder :

- Connectez-vous à votre tableau de bord Cloudflare.

- Dans le menu de gauche, déroulez la section « Sécurité » et cliquez sur « Bots ».

- Sur la page qui s’ouvre, repérez l’option « Bloquer les récupérateurs et robots d’indexation de l’IA ».

- Activez simplement l’interrupteur associé à cette option.

✅ Et voilà, Cloudflare se chargera dorénavant de bloquer automatiquement les robots IA identifiés comme nuisibles pour votre site web. Cette fonctionnalité est régulièrement mise à jour par Cloudflare pour s’adapter aux nouvelles techniques utilisées par les bots IA, vous assurant ainsi une protection optimale et pérenne.

Conclusion

Face à la menace croissante des robots IA qui explorent et pillent les sites web sans vergogne, il est primordial de prendre les devants pour protéger votre contenu original. Que vous optiez pour un blocage manuel via le fichier robots.txt ou pour la solution clé en main proposée par Cloudflare, vous disposez désormais des outils nécessaires pour reprendre le contrôle et empêcher ces robots IA de crawler votre site web.